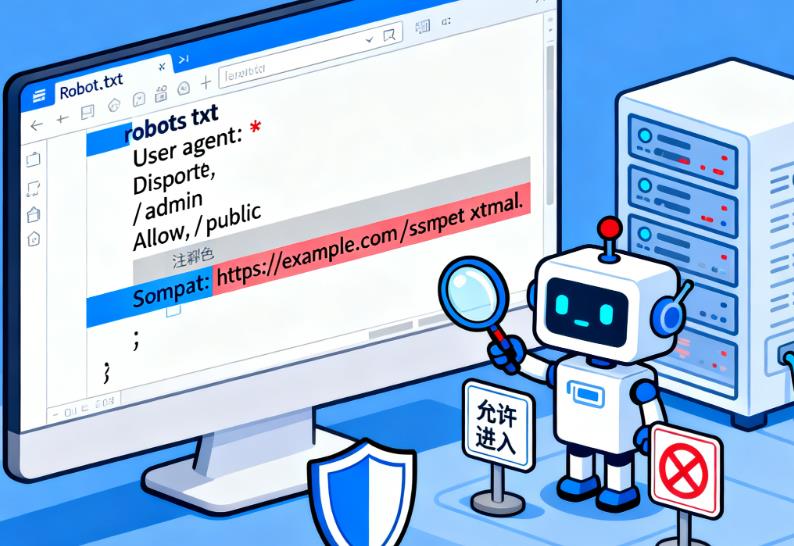

robots文件怎么写?robots文件写法

robots.txt 语法简洁,核心由 “用户代理(User-agent)” 和 “访问规则(Disallow/Allow)” 构成,支持通配符扩展,无需专业技术即可编写:

1. robots文件语法规则

(1)User-agent:指定规则适用的搜索引擎爬虫,* 代表所有爬虫,也可指定具体爬虫(如百度蜘蛛 Baiduspider、谷歌爬虫 Googlebot)。

示例:User-agent: Baiduspider(仅对百度爬虫生效)

(2)Disallow:禁止抓取的目录或页面,以 / 开头表示根目录。

示例:Disallow: /admin/(禁止抓取 /admin 目录下所有内容)、Disallow: /test.html(禁止抓取单个页面)

Allow:允许抓取的目录或页面,用于在 “禁止整体” 中例外放行部分内容(部分搜索引擎支持)。

示例:Disallow: /seo/ + Allow: /seo/50/(禁止抓取 /seo/ 目录,但放行 /seo/50 / 子目录)

2. robots文件通配符用法(进阶扩展)

(1)*:匹配任意字符(0 个或多个),用于批量匹配规则。

示例:Disallow: /*.pdf(禁止抓取所有 PDF 文件)

(2)$:匹配 URL 结尾,用于精准匹配特定后缀或页面。

示例:Allow: *.htm$(仅允许抓取.htm 后缀的文件,不含.html)。

3. robots文件关联站点地图(Sitemap)

通过Sitemap指令告知爬虫站点地图的位置,帮助其快速发现所有核心页面,格式为完整 URL:

示例:Sitemap: https://example.com/sitemap.xml。

User-agent: * # 对所有搜索引擎生效 Disallow: /admin/ # 禁止抓取后台目录 Disallow: /private/ # 禁止抓取隐私目录 Disallow: /*.pdf # 禁止抓取所有PDF文件 Allow: /admin/public/ # 例外放行admin目录下的public子目录 Sitemap: https://example.com/sitemap.xml # 关联站点地图